1. 정보량(Information)과 확률의 관계

정보량이란?

정보이론에서 정보(Information)란, 예측하기 어려운 사건이 발생할 때 얻을 수 있는 것을 의미합니다.

정보량 공식

우리는 어떤 사건이 발생했을 때, 그 사건이 얼마나 "놀라운지"에 따라 정보량을 측정할 수 있습니다.

🎲 예제: 주사위 던지기

- 공정한 주사위를 던졌을 때, 특정 숫자가 나올 확률은 1/6.

- 조작된 주사위라면 특정 숫자가 나올 확률이 90%일 수도 있음.

✅ 확률이 낮은 사건이 발생하면 더 많은 정보를 줍니다.

✅ 확률이 높은 사건은 이미 예측 가능하므로 정보가 적습니다.

이를 수식으로 표현하면:

정보량(I) = -log(p)

- 확률 p가 클수록 I 값은 작아짐 → 정보량이 적음

- 확률 p가 작을수록 I 값은 커짐 → 정보량이 많음

사건확률 (p)정보량 (-log p)

| 공정한 주사위에서 특정 숫자 | 1/6 | 2.58 bits |

| 조작된 주사위에서 특정 숫자 | 0.9 | 0.15 bits |

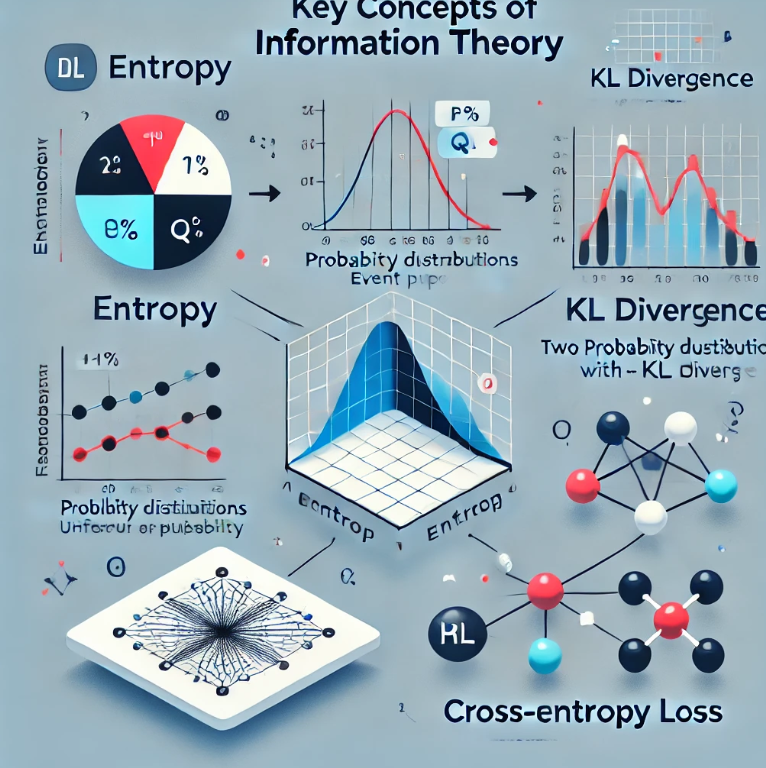

2. 엔트로피(Entropy): 평균적인 불확실성

엔트로피란?

한 사건이 아니라, 전체 확률 분포의 정보량을 어떻게 측정할까?

바로 **엔트로피(Entropy)**를 사용하면 됩니다.

엔트로피 공식

엔트로피는 모든 사건에 대한 정보량의 평균입니다.

엔트로피(H) = - Σ p * log(p)

🎲 예제: 공정한 vs 조작된 주사위

- 공정한 주사위 → H가 큼 (모든 숫자가 나올 확률이 균등 → 예측 어려움)

- 조작된 주사위 → H가 작음 (특정 숫자가 나올 확률이 높음 → 예측 쉬움)

✅ 불확실성이 높을수록 엔트로피가 큼.

✅ 예측이 쉬운 시스템(=조작된 주사위)은 엔트로피가 낮음.

3. KL 다이버전스: 모델과 실제 데이터의 차이

KL 다이버전스란?

우리가 만든 모델이 실제 데이터를 얼마나 잘 예측하는가?

이를 측정하는 지표가 **KL 다이버전스(Kullback-Leibler Divergence)**입니다.

KL 다이버전스 공식

KL 다이버전스는 실제 확률 분포 P(x)와 모델의 예측 확률 분포 Q(x)의 차이를 측정합니다.

KL 다이버전스 D_KL(P || Q) = Σ p * log (p / q)

- P(x): 실제 데이터의 확률 분포 (Ground Truth)

- Q(x): 모델이 예측한 확률 분포

⛅ 예제: 기상청 예측 모델

- 실제 날씨 확률 P(x):

- 맑음: 50%, 비: 30%, 눈: 20%

- 기상청 모델 Q(x):

- 맑음: 70%, 비: 20%, 눈: 10%

✅ KL 다이버전스 값이 클수록 모델과 실제 데이터가 많이 다름

✅ KL 값이 0이면 모델이 완벽하게 맞음

사건실제 확률 P(x)모델 예측 Q(x)P/Q

| 맑음 | 0.5 | 0.7 | 0.71 |

| 비 | 0.3 | 0.2 | 1.5 |

| 눈 | 0.2 | 0.1 | 2 |

💡 KL 다이버전스 최소화 → 모델을 실제 데이터에 가깝게 만들기!

4. 크로스 엔트로피: 딥러닝의 손실 함수

크로스 엔트로피란?

딥러닝에서 KL 다이버전스를 최적화할 때, 크로스 엔트로피를 쓰는 이유는 뭘까?

크로스 엔트로피 공식

KL 다이버전스를 변형하면:

KL 다이버전스 = - Σ p * log(q) + Σ p * log(p)

- 첫 번째 항목: 크로스 엔트로피

- 두 번째 항목: 실제 데이터의 엔트로피 (상수)

✅ 결론:

딥러닝에서 크로스 엔트로피를 최소화하면 KL 다이버전스도 최소화됨.

크로스 엔트로피 H(P, Q) = - Σ p * log(q)

5. 전체 개념 연결

개념설명직관적 예제

| 정보량 (-log p) | 확률이 낮을수록 정보량이 많음 | 룰렛에서 0이 나올 확률 |

| 엔트로피 (H = -Σ p log p) | 확률 분포의 평균적인 불확실성 | 공정한 vs 조작된 주사위 |

| KL 다이버전스 (D_KL = Σ p log (p/q)) | 모델과 실제 분포의 차이 | 기상청 날씨 예측 |

| 크로스 엔트로피 (H(P, Q) = -Σ p log q) | KL 다이버전스를 최소화하는 손실 함수 | 딥러닝에서 분류 손실 함수로 사용 |

6. 최종 요약

- 정보량: 예측하기 어려운 사건일수록 정보량이 많음.

- 엔트로피: 전체 확률 분포의 불확실성(평균 정보량).

- KL 다이버전스: 모델이 실제 데이터 분포와 얼마나 다른지 측정.

- 크로스 엔트로피: KL 다이버전스를 최소화하는 손실 함수로 딥러닝에서 사용됨.

✅ 이제 정보이론과 딥러닝 모델 손실 함수의 연결까지 완벽히 이해! 🚀

'AI' 카테고리의 다른 글

| 왜 정보량(Information Content)은 로그(log)를 씌울까? (0) | 2025.02.20 |

|---|